Informe de cumplimiento de las Normas de la comunidad

1 de julio de 2020 – 31 de diciembre de 2020

Publicado: 24 de febrero de 2021

Acerca de este informe

TikTok es una comunidad diversa y global basada en la expresión creativa. Trabajamos para mantener un entorno en el que todo el mundo se sienta seguro y cómodo para crear vídeos, pertenecer a una comunidad y pasar un rato divertido. Creemos que sentirse seguro es esencial para expresarse con autenticidad, por lo que velamos por el cumplimento de nuestras Normas de la comunidad eliminando las cuentas y el contenido que las infringen. Nuestro objetivo es que TikTok siga siendo un lugar de inspiración, creatividad y alegría.

Nos comprometemos a ser transparentes en cuanto a la aplicación de nuestras políticas, porque eso ayuda a generar confianza en nuestra comunidad y nos hace responsables ante ella. Publicamos informes de transparencia para dar visibilidad al volumen y la naturaleza de los contenidos eliminados por infringir nuestras Normas de la comunidad o los Términos de servicio.

Últimos datos

Vídeos

Durante el segundo semestre del 2020 (del 1 de julio al 31 de diciembre), se eliminaron 89.132.938 vídeos a nivel mundial por incumplimiento de nuestras Normas de la comunidad o los Términos de servicio, lo que supone menos del 1 % de todos los vídeos subidos a TikTok. De esos vídeos, identificamos y eliminamos el 92,4 % antes de que nadie los denunciara, el 83,3 % antes de que recibieran ninguna visita y el 93,5 % en las 24 horas siguientes a su publicación.

Esta tabla muestra los cinco mercados con mayor volumen de vídeos eliminados.

| País / Mercado | Vídeos eliminados |

| Estados Unidos | 11,775,777 |

| Paquistán | 8,215,633 |

| Brasil | 7,506,599 |

| Rusia | 4,574,690 |

| Indonesia | 3,860,156 |

Debido a la pandemia, seguimos confiando en la tecnología para detectar y eliminar automáticamente contenidos infractores en algunos mercados, como Brasil y Pakistán. Un volumen extra de 8.295.164 videos fueron marcados y eliminados automáticamente por infringir nuestras Normas de la comunidad. Esos vídeos no están incluidos en los gráficos siguientes.

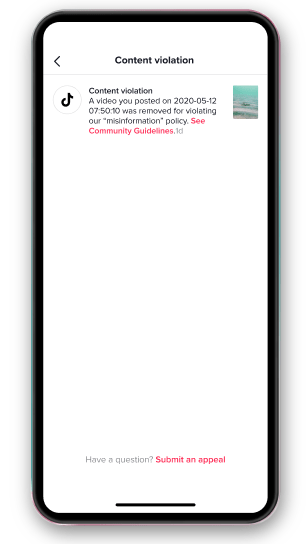

TikTok ofrece a los creadores la posibilidad de apelar la eliminación de su vídeo. Cuando recibimos una solicitud de apelación, revisamos el vídeo por segunda vez y, si determinamos que no infringe nuestras políticas, permitimos su publicación. En el último semestre, hemos restituido 2.927.391 vídeos después del proceso de apelación.

Este gráfico muestra el volumen de vídeos eliminados por incumplimiento de políticas. Un vídeo puede incumplir varias políticas, y el gráfico refleja cada uno de los incumplimientos detectados.

De los vídeos eliminados por nuestro equipo de moderación, el siguiente gráfico muestra el porcentaje de vídeos eliminados de forma proactiva por motivos de política. Llamamos «eliminación proactiva» al hecho de detectar y eliminar un vídeo antes de que nadie lo denuncie. Llamamos «eliminación en un plazo de 24 horas» al hecho de eliminar un vídeo en las 24 horas siguientes a su publicación en nuestra plataforma.

| Eliminación proactiva | Eliminación en 24 horas | |

| Desnudez y actividades sexuales de adultos | 88.30% | 90.60% |

| Acoso e intimidación | 66.50% | 84.10% |

| Conductas motivadas por el odio | 72.90% | 83.50% |

| Actividades ilegales y bienes regulados | 96.30% | 94.80% |

| Integridad y autenticidad | 70.50% | 91.30% |

| Seguridad de menores | 97.10% | 95.80% |

| Suicidio, autolesiones y actos peligrosos | 94.40% | 91.90% |

| Contenidos violentos y gráficos | 93.20% | 92.70% |

| Extremismo violento | 86.90% | 89.40% |

Desnudez y actividades sexuales de adultos

Nuestro objetivo es crear una plataforma que resulte acogedora y segura, y eliminamos los desnudos y el contenido sexualmente explícito. . De los vídeos eliminados, el 20,5 % infringía esta política, lo que supone un descenso respecto al 30,9 % del primer semestre del 2020. Uno de los motivos de este descenso se debe a la mejora de nuestros sistemas de clasificación que separan la desnudez adulta de la de menores. Eliminamos el 88,3 % de estos vídeos antes de que nadie los denunciara y el 90,6 % en las 24 horas siguientes a su publicación.

Acoso e intimidación

Creemos en una comunidad inclusiva y en la expresión individualizada sin miedo al abuso, y no toleramos que los miembros de nuestra comunidad sean avergonzados, intimidados o acosados. De los vídeos que eliminamos, el 6,6 % infringía esta política, lo que supone un aumento del 2,5 % respecto al primer semestre del 2020. Este aumento refleja los ajustes a las políticas relacionadas con el acoso sexual, la amenaza de la piratería informática y las declaraciones de acoso, que ahora son más exhaustivas. Además, hemos observado modestas mejoras en nuestra capacidad de detectar el acoso o la intimidación de forma proactiva, algo que sigue siendo un reto por los matices lingüísticos y culturales. De estos vídeos, eliminamos el 66,5 % antes de que nadie los denunciara y el 84,1 % en las 24 horas siguientes a su publicación. Nos comprometemos a eliminar esta brecha y mantendremos a nuestra comunidad informada a medida que continuemos progresando en este ámbito.

Conductas motivadas por el odio

TikTok es una comunidad diversa e inclusiva que no tolera las conductas motivadas por el odio. El año pasado modificamos el nombre de esta política: pasó de llamarse «discursos de odio» a «conductas motivadas por el odio», que refleja un enfoque más amplio en la lucha contra las ideologías de odio y las actividades fuera de la plataforma. Como resultado, el 2 % de los vídeos que eliminamos infringían esta política, frente al 0,8 % del primer semestre del 2020. Disponemos de sistemas para detectar símbolos de odio, como banderas e iconos, pero la detección proactiva de la incitación al odio sigue siendo un reto y estamos invirtiendo recursos para mejorar en este aspecto. Eliminamos el 72,9 % de los vídeos de conductas motivadas por el odio antes de que nadie los denunciara y el 83,5 % en las 24 horas siguientes a su publicación.

Actividades ilegales y bienes regulados

Trabajamos para asegurarnos de que TikTok no permita actividades que infrinjan las leyes o la regulación. El 17,9 % del total de vídeos eliminados infringían esta política. Esto supone un ligero descenso respecto al 19,6 % del primer semestre del 2020. Lo atribuimos a las mejoras relacionadas con nuestros sistemas de automatización y detección, así como al refuerzo de los flujos de trabajo. Eliminamos el 96,3 % de estos vídeos antes de que nadie los denunciara y el 94,8 % en las 24 horas siguientes a su publicación.

Integridad y autenticidad

Creemos que la confianza es la base de nuestra comunidad, y no permitimos contenidos o cuentas que exhiban interacciones falsas, suplantaciones de identidad o información errónea. Del total de vídeos eliminados, el 2,4 % infringía esta política, frente al 1,2 % del primer semestre del 2020. Nos hemos asociado con verificadores de informaciones en mercados adicionales y ahora podemos llevar a cabo esta tarea en 16 idiomas. Esto nos ayuda a evaluar con mayor precisión los contenidos y a eliminar la información errónea. También hemos mejorado nuestra capacidad de detectar y eliminar las interacciones falsas y el spam. Eliminamos el 70,5 % de los vídeos antes de que nadie los denunciara y el 91,3 % en las 24 horas siguientes a su publicación. Estamos invirtiendo en nuestra infraestructura para mejorar la detección proactiva, especialmente cuando se trata de identificar la información errónea o desinformación.

Seguridad de menores

Tenemos un gran compromiso con la seguridad de los menores , y en el 2020 hicimos cambios sustanciales para reforzar esta política, incluyendo la adición de una política de actividades perjudiciales por la que eliminamos contenidos, como retos, desafíos y acrobacias, que pueden ser más arriesgados para los menores que para los adultos. Como resultado, el 36 % de todo el contenido que eliminamos infringía esta política, frente al 22,3 % del primer semestre del 2020. De esos vídeos, eliminamos el 97,1 % antes de que nadie los denunciara y el 95,8 % en las 24 horas siguientes a su publicación.

TikTok se sirve de PhotoDNA para censurar la pornografía infantil, y hemos seguido invirtiendo en nuestros propios sistemas de identificación de este tipo de contenidos. Estos esfuerzos han mejorado aún más nuestra capacidad de eliminar y denunciar contenidos y cuentas al Centro Nacional para Menores Desaparecidos y Explotados (NCMEC) de Estados Unidos y a las autoridades legales pertinentes. Como parte de este compromiso, en el 2020 presentamos un total de 22.692 denuncias ante el NCMEC, frente a las 596 del 2019.

Suicidio, autolesiones y actos peligrosos

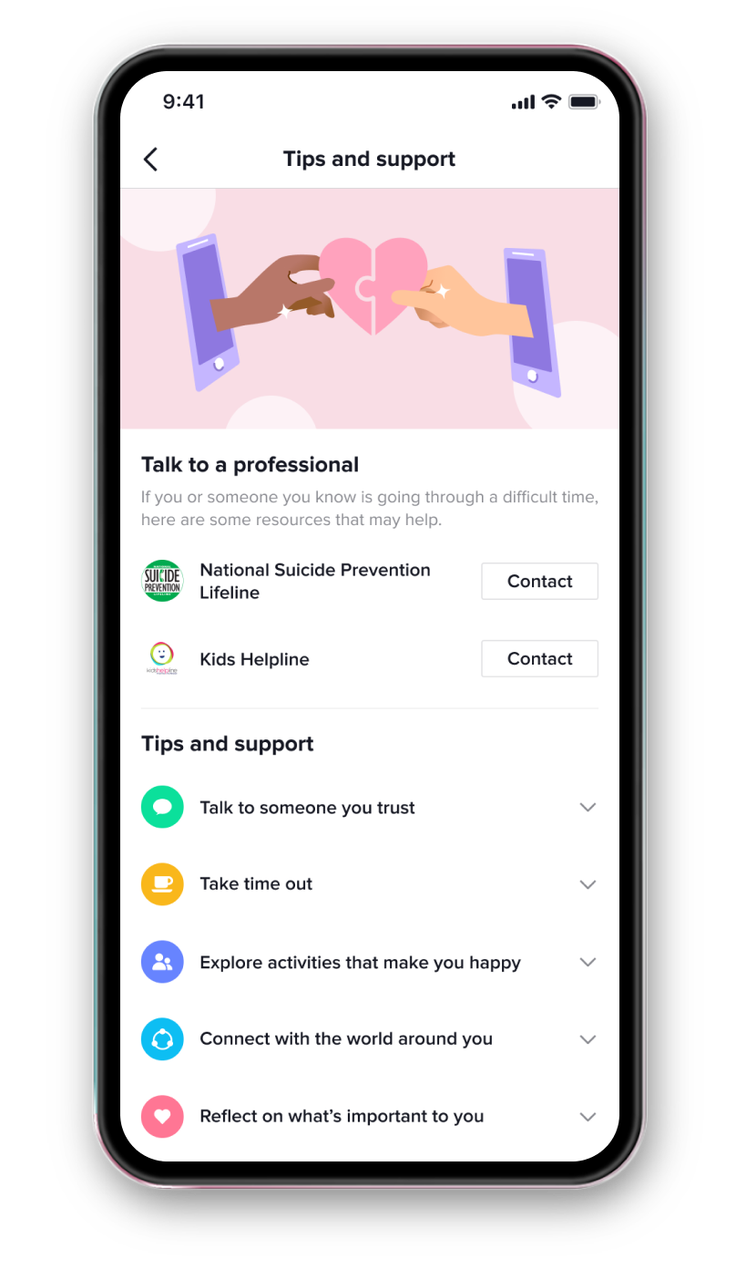

Nos preocupamos por la salud y el bienestar de las personas que componen nuestra comunidad. En el segundo semestre del 2020, actualizamos nuestras políticas sobre autolesiones, suicidio y trastornos de la conducta alimentaria para reflejar las aportaciones y el lenguaje utilizado por los expertos en salud mental. También nos asociamos con una serie de organizaciones para apoyar a las personas que puedan estar pasando por este tipo de enfermedades. Dirigimos las búsquedas y los hashtags pertinentes a la línea de ayuda de la National Eating Disorder Association, a la línea de mensajes de texto para crisis o a la National Suicide Prevention Lifeline. De todos los vídeos eliminados, el 6,2 % infringían estas políticas, lo que supone un descenso respecto al 13,4 % del primer semestre del 2020, en parte porque ahora eliminamos los contenidos que muestran conductas peligrosas o arriesgadas por parte de menores en virtud de nuestra nueva política de seguridad de los menores y de prohibición de las actividades perjudiciales. De estos vídeos, eliminamos el 94,4 % antes de que nadie los denunciara y el 91,9 % en las 24 horas siguientes a su publicación.

Extremismo violento

Adoptamos una postura firme en contra de la violencia tanto dentro como fuera de TikTok. Cuando actualizamos nuestras Normas de la comunidad el pasado otoño, esta política cambió su nombre de «individuos y organizaciones peligrosas» a «extremismo violento» con la idea de abordar este reto de forma exhaustiva y especificar lo que TikTok considera una amenaza o una incitación a la violencia. Del total de vídeos eliminados, el 0,3 % infringía esta política, una cifra similar a la del primer semestre del 2020. De estos vídeos, eliminamos el 86,9 % antes de que nadie los denunciara y el 89,4 % en las 24 horas siguientes a su publicación.

Contenido violento y gráfico

TikTok es una plataforma que celebra la creatividad, pero no la creación de impactos negativos ni de la violencia. Del total de vídeos eliminados, el 8,1 % infringieron esta política, frente al 8,7 % del primer semestre del 2020. De estos vídeos, eliminamos el 93,2 % antes de que nadie los denunciara y el 92,7 % en las 24 horas siguientes a su publicación. Con fines documentales, permitimos que los vídeos que documenten protestas violentas, animales cazando en la naturaleza y otros contenidos de este tipo permanezcan en nuestra plataforma. Como resultado hemos introducido pantallas de visualización opcionales para que los usuarios tengan más control sobre los vídeos que ven.

Cuentas

En el segundo semestre del 2020, eliminamos 6.144.040 cuentas por infringir nuestras Normas de la comunidad. Además, eliminamos otras 9.499.881 cuentas de spam y 5.225.800 vídeos basura publicados por esas cuentas. Hemos evitado la creación de 173.246.894 cuentas por parte de spammers.

Anuncios

TikTok se rige por políticas estrictas para proteger a los usuarios de contenidos falsos, fraudulentos o engañosos, incluidos los anuncios. Las cuentas de los anunciantes y el contenido de los anuncios están sujetos a estas políticas y deben adherirse a nuestras Normas de la comunidad, Normas de publicidad y Términos de servicio. En el segundo semestre del 2020, eliminamos 3.501.477 anuncios por infringir nuestras políticas y normas de publicidad. Nos comprometemos a crear un entorno seguro y positivo para nuestros usuarios, y revisamos y reforzamos frecuentemente nuestros sistemas para combatir los anuncios que no se adhieren a nuestras políticas.

Resumen

Invertimos constantemente en políticas, productos y asociaciones para fomentar la salud general de nuestra comunidad. Estas son algunas de las principales actualizaciones que hemos puesto en marcha durante el segundo semestre del 2020.

Abogamos por el bienestar de la comunidad

Hemos reforzado nuestras Normas de la comunidad para promover el bienestar de la comunidad basándonos en el comportamiento que observamos en la plataforma y en los comentarios que recibimos de nuestra comunidad y de los expertos. Por ejemplo, nuestras nuevas políticas sobre autolesiones, suicidio y trastornos de la conducta alimentaria reflejan los comentarios actualizados y el lenguaje proporcionado por expertos en salud mental. Nuestras políticas publicitarias ahora prohíben los anuncios de aplicaciones de ayuno y de suplementos para la pérdida de peso. Y hemos mejorado la forma en que enviamos avisos de eliminación de vídeos a los usuarios para ayudarles a entender por qué eliminamos su contenido.

TikTok se asocia con una serie de organizaciones para apoyar a las personas que puedan exhibir trastornos de la conducta alimentaria, comportamientos autolesivos o pensamientos suicidas. Ahora, las búsquedas y los hashtags relevantes son redirigidos a la línea de soporte de emergencia donde los usuarios pueden acceder al apoyo gratuito y confidencial. También proporcionamos recursos sobre los pasos contrastados que alguien puede tomar para mejorar su salud emocional.

Apoyamos a las familias de TikTok

Conversamos periódicamente con padres, adolescentes y expertos en seguridad juvenil para desarrollar métodos que permitan a las familias crear una experiencia en TikTok que sea adecuada para ellas. A finales del 2020, ampliamos nuestras funciones de vinculación familiar para brindar a los padres la opción de establecer más límites de contenido y configurar los ajustes de privacidad de sus hijos adolescentes. Esperamos que estas herramientas, que permiten restringir búsquedas y comentarios y limitar el tiempo de pantalla, animen a las familias a entablar conversaciones más amplias sobre la seguridad digital.

Sí

Sí No

No